🚀 Proyecto de Data Engineering en AWS: Pipeline ETL End-to-End

- Brayan Neciosup

- hace 5 días

- 1 Min. de lectura

En este proyecto desarrollo un flujo ETL (Extract, Transform, Load) completamente funcional sobre AWS, enfocado en replicar un escenario real de ingeniería de datos, desde la ingestión hasta la carga en un data warehouse.

El objetivo principal es demostrar cómo integrar distintos servicios de AWS de forma correcta, segura y alineada a buenas prácticas de Data Engineering.

🧩 Arquitectura del proyecto

La arquitectura se apoya en los siguientes componentes:

Amazon S3: almacenamiento de los archivos fuente (data lake)

AWS Glue:

Crawlers para inferir esquemas

Data Catalog para gestión de metadatos

Visual ETL para transformaciones y orquestación

Amazon Redshift Serverless: data warehouse para análisis

IAM: gestión de roles y permisos bajo el principio de mínimo privilegio

VPC + Endpoint a S3: conectividad privada y segura entre servicios

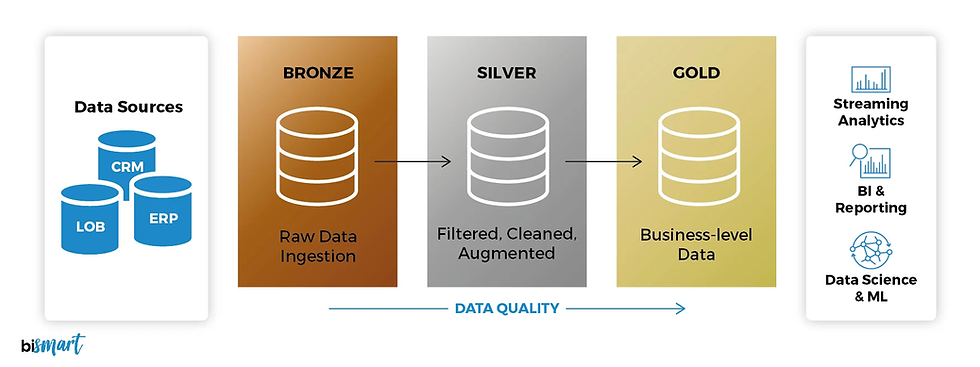

🔄 Flujo de datos

Los datos se almacenan inicialmente en Amazon S3

AWS Glue Crawler infiere el esquema y crea las tablas en el Data Catalog

El Visual ETL realiza:

Eliminación de filas nulas

Eliminación de duplicados

Transformaciones con SQL

Ajuste de tipos de datos para Redshift

Los datos transformados se cargan en Amazon Redshift Serverless

📺 Documentación y recursos

📹 YouTube: explicación paso a paso del proyecto y cada decisión técnica (Link-Playlist).

📂 GitHub: scripts, queries SQL y documentación completa del proceso (Link-Repositorio).

Este proyecto está orientado a aprendizaje práctico y sirve como base para comprender cómo funcionan los pipelines de datos modernos en la nube.

Comentarios