De DBFS a Unity Catalog: El antes y después de Databricks en la gestión de archivos 🗂️

- Brayan Neciosup

- 30 jul 2025

- 2 Min. de lectura

Cuando comencé mi camino con Apache Spark dentro de Databricks (Community Edition), uno de los pilares más importantes fue entender el funcionamiento del Databricks File System (DBFS). Más allá de un simple sistema de almacenamiento, DBFS era una infraestructura completa de organización, procesamiento y control de archivos, fundamental para los flujos de trabajo en Spark.

Hoy, con la llegada de Unity Catalog en la nueva Databricks Free Edition 2025, las cosas han cambiado, pero antes de abrazar el nuevo estándar, vale la pena dejar asentado el valor y funcionamiento detallado del DBFS, como parte de mi proceso de aprendizaje y consolidación de conocimientos.

🗂️ ¿Qué era el DBFS?

DBFS es el sistema de archivos virtual de Databricks, donde podíamos almacenar, organizar y gestionar todos los elementos que conformaban un pipeline de datos. La ruta base: /FileStore/

Desde ahí, estructurábamos carpetas especializadas:

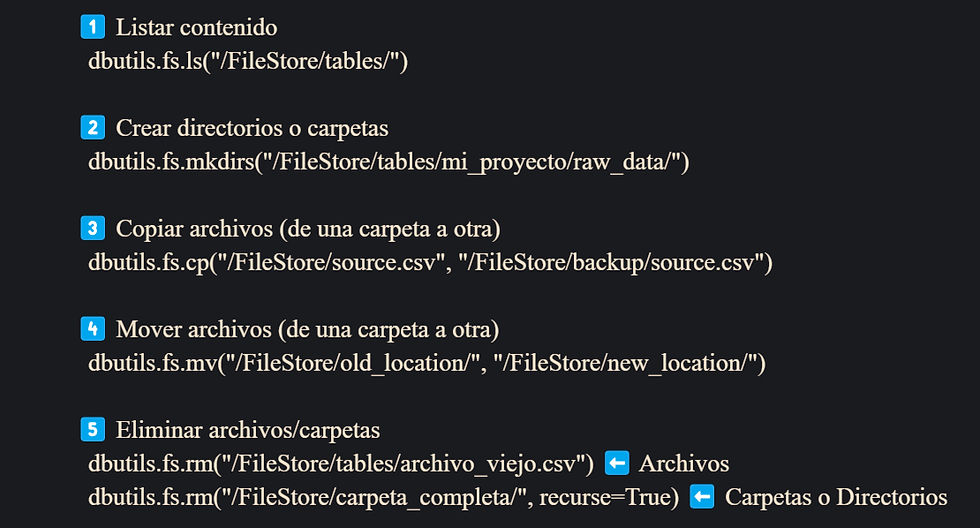

🔧 Gestión avanzada con dbutils.fs

Sin necesidad de importar librerías externas, dbutils.fs ofrecía una forma poderosa de trabajar con el sistema:

🔖 También se podían cargar archivos, crear backups con timestamps, leer configuraciones, ejecutar scripts y montar almacenamiento externo.

📊 Manejo de tablas

Con Spark SQL, era posible crear tablas permanentes y externas:

Además, Databricks nos introdujo a Delta Lake, donde cada tabla podía tener versionamiento y transacciones ACID. ➡️En próximas publicaciones detallaré mas acerca de SparkSQL 📊.

🧠 Automatización, ML y más

DBFS también permitía:

Guardar modelos con joblib o Spark ML.

Registrar logs de procesos y ETLs.

Ejecutar scripts reutilizables para limpieza o transformación.

Almacenar configuraciones dinámicas como claves de API o URLs de base de datos.

📌 Transición al Unity Catalog

Con el avance hacia la Free Edition 2025, Databricks reemplaza en gran parte al DBFS por Unity Catalog, que ofrece:

Mayor control y trazabilidad de los assets de datos.

Gobernanza unificada para datos, metadatos y permisos.

Integración nativa con S3, GCS, Azure y más.

Aunque el DBFS aún existe y es funcional, ahora está integrado de forma más transparente y controlada bajo este nuevo modelo.

📌 Conclusión:

Entender el funcionamiento de DBFS fue clave, porque me permitió dominar las bases de almacenamiento, versionamiento, ejecución de scripts y automatización de procesos dentro del ecosistema Spark.

📘 Hoy Unity Catalog representa una evolución, pero llevar esos fundamentos en la mochila te permite aprovechar esta nueva etapa con madurez y visión de arquitecto.

Comentarios